教授团队突破人工智能可解释性难题,助力AI软件开发高质量发展

软件工程学院(滴水湖国际软件学院)杜德慧教授课题组在人工智能可解释性研究领域取得重要进展,相关成果为解决AI模型"黑箱"问题提供了创新方案,有力推动了人工智能应用软件开发的可靠性与实用性发展。

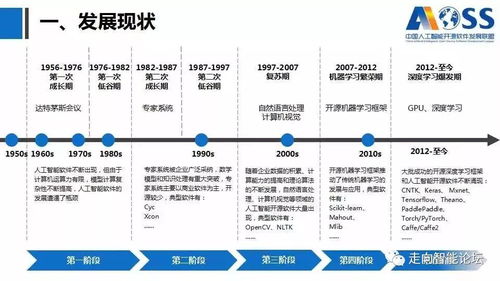

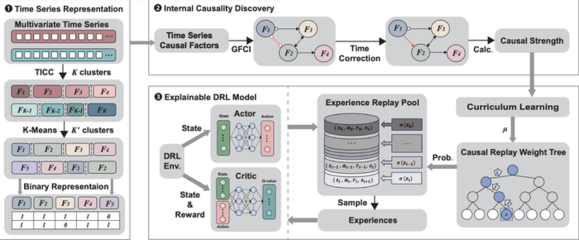

人工智能技术已广泛应用于医疗诊断、金融风控、自动驾驶等关键领域,但其决策过程的不透明性一直是制约行业发展的瓶颈。杜德慧教授团队通过构建新型可解释神经网络架构,实现了对深度学习模型决策逻辑的精准解析与可视化展示。该技术不仅能够准确追踪模型推理路径,还能生成人类可理解的特征重要性分析报告,显著提升了AI系统的透明度和可信度。

在应用软件开发层面,课题组研发的可解释性模块已成功集成到多个行业解决方案中。以智慧医疗软件为例,该技术使诊断AI能够清晰展示其判断依据,医生可据此验证诊断结果的合理性;在金融科技领域,风控系统可明确提示风险判断的关键因素,大幅提升了业务决策的可靠性。

杜德慧教授表示:"我们的研究致力于在保持模型性能的同时增强其可解释性,这既是技术挑战,也是伦理需求。未来团队将继续深耕可解释AI与软件工程的交叉领域,为构建更安全、更可信的人工智能系统提供理论基础和技术支撑。"

该研究成果已获得多项国家发明专利,并在国际顶级期刊发表系列论文,受到业内专家的高度评价。行业分析认为,此项突破将加速可解释AI技术在工业界的落地应用,为人工智能应用软件开发树立新的质量标杆。

如若转载,请注明出处:http://www.cfcmf.com/product/6.html

更新时间:2026-03-01 19:30:30